Lvmin Zhang en Github, en colaboración con Maneesh Agrawala en la Universidad de Stanford, ha introducido FramePack esta semana. FramePack ofrece una implementación práctica de la difusión de video utilizando un contexto temporal de longitud fija para un procesamiento más eficiente, lo que permite videos más largos y de mayor calidad. Un modelo de parámetros de 13 mil millones construido con la arquitectura de FramePack puede generar un clip de 60 segundos con solo 6 GB de memoria de video.

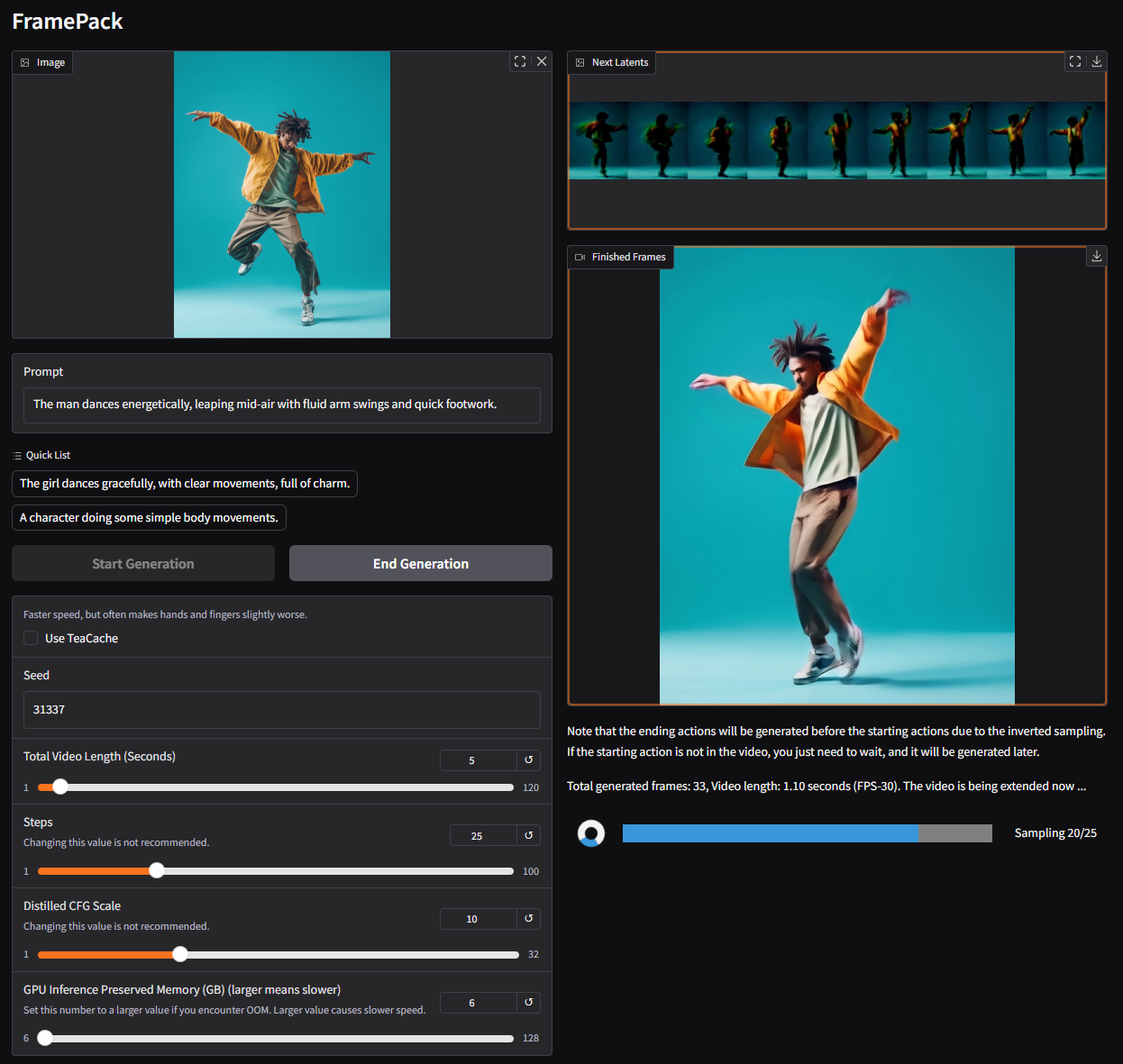

FramePack es una arquitectura de red neuronal que utiliza técnicas de optimización de varias etapas para habilitar la generación de videos de IA locales. Al momento de escribir este artículo, se dice que la GUI de FramePack ejecuta un modelo personalizado con sede en Hunyuan bajo el capó, aunque el trabajo de investigación menciona que los modelos previamente capacitados existentes pueden ajustarse utilizando FramePack.

Los modelos de difusión típicos procesan datos de marcos ruidosos generados previamente para predecir el siguiente marco un poco menos ruidoso. El número de marcos de entrada considerados para cada predicción se llama longitud del contexto temporal, que crece con el tamaño del video. Los modelos de difusión de video estándar exigen una gran piscina VRAM, con 12 GB de ser un punto de partida común. Claro, puede salirse con la suya con menos memoria, pero eso tiene costo de clips más cortos, menor calidad y tiempos de procesamiento más largos.

Ingrese FramePack: una nueva arquitectura que comprime los marcos de entrada, según su importancia, en una longitud de contexto de tamaño fijo, reduciendo drásticamente la sobrecarga de la memoria de GPU. Todos los cuadros deben comprimirse para converger en un límite superior deseado para la longitud de contexto. Los autores describen los costos computacionales como similares a la difusión de imágenes.

Junto con las técnicas para mitigar la “deriva”, donde la calidad se degrada con la longitud del video, FramePack ofrece una generación de video más larga sin un compromiso significativo para la fidelidad. Tal como está, FramePack requiere una GPU de la serie RTX 30/40/50 con soporte para los formatos de datos FP16 y BF16. No se ha verificado el soporte de arquitecturas de Turing y mayores, sin mencionar el hardware AMD/Intel. Linux también se encuentra entre los sistemas operativos compatibles.

Además de las GPU RTX 3050 4GB, la mayoría de las GPU modernas (RTX) cumplen o exceden los criterios de 6GB. En términos de velocidad, un RTX 4090 puede repartir hasta 0.6 cuadros/segundo (optimizado con Teacache), por lo que su kilometraje variará según su tarjeta gráfica. De cualquier manera, cada cuadro se mostrará después de que se genere, proporcionando retroalimentación visual inmediata.

El modelo empleado probablemente tenga un límite de 30 fps, que podría ser limitante para muchos usuarios. Dicho esto, en lugar de confiar en costosos servicios de terceros, FramePack está allanando el camino para hacer que la generación de videos de IA sea más accesible para el consumidor promedio. Incluso si no eres un creador de contenido, esta es una herramienta entretenida para hacer GIF, memes y otras cosas. Sé que lo intentaré en mi tiempo libre.