Mientras AI Hype impregna Internet, los líderes tecnológicos y empresariales ya están mirando hacia el siguiente paso. AGI, o inteligencia general artificial, se refiere a una máquina con inteligencia y capacidades humanas. Si los sistemas de IA de hoy están en camino a AGI, necesitaremos nuevos enfoques para garantizar que tal máquina no funcione en contra de los intereses humanos.

Desafortunadamente, no tenemos nada tan elegante como las tres leyes de robótica de Isaac Asimov. Los investigadores de Deepmind han estado trabajando en este problema y han publicado un nuevo artículo técnico (PDF), que puede descargar a su conveniencia.

Contiene una gran cantidad de detalle, registrando 108 páginas. antes referencias. Mientras que algunos en el campo de la IA creen que AGI es un sueño imposible, los autores del Proyecto Paper DeepMind que podría suceder para 2030. Con eso en mente, pretendían comprender los riesgos de una inteligencia sintética humana, que reconocen que podría conducir a un “daño severo”.

Todas las formas en que Agi podría chupar por la humanidad

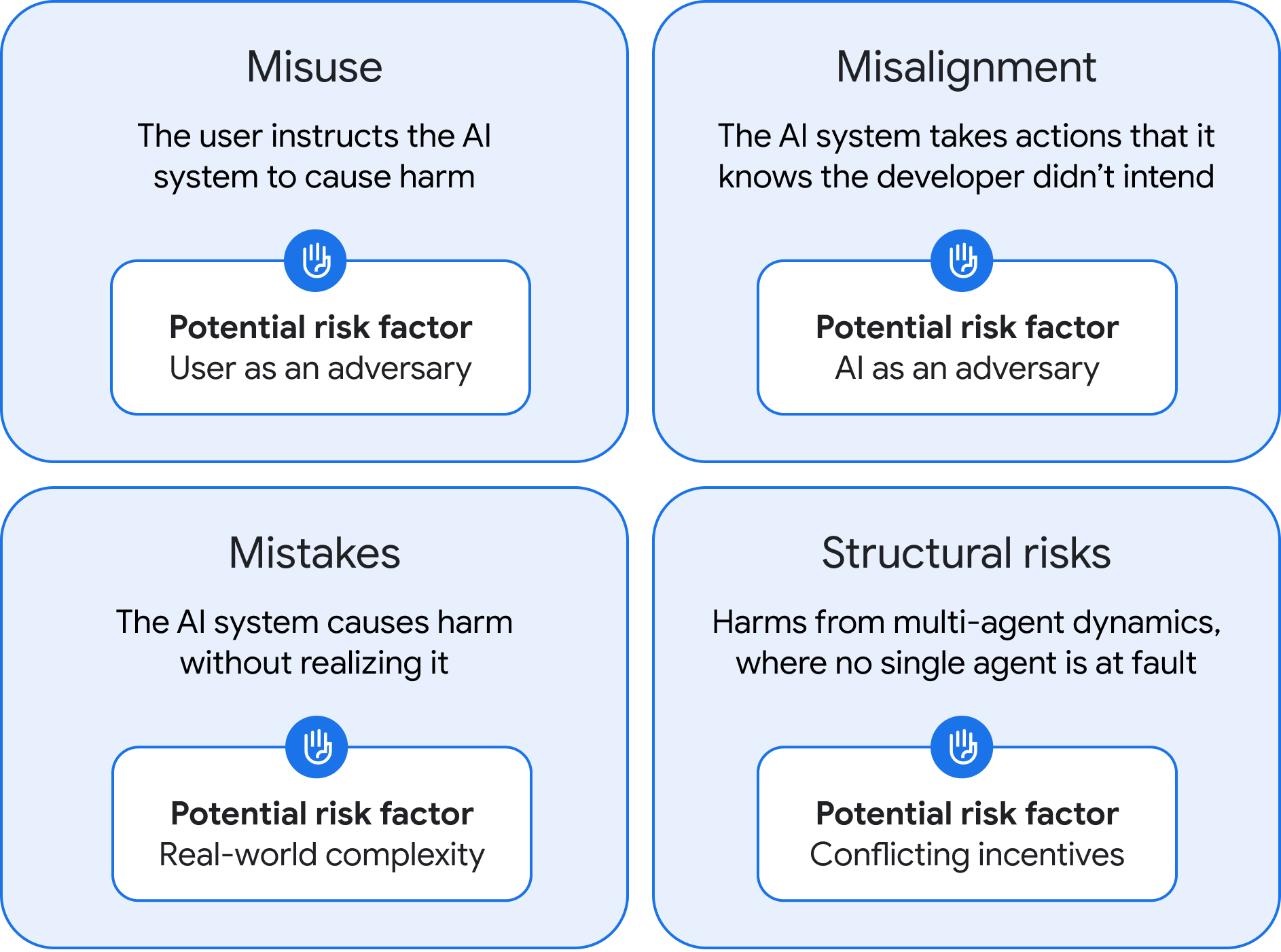

Este trabajo ha identificado cuatro posibles tipos de riesgo AGI, junto con sugerencias sobre cómo podríamos mejorar dichos riesgos. El equipo de DeepMind, dirigido por el cofundador de la compañía, Shane Legg, clasificó los resultados negativos de AGI como mal uso, desalineación, errores y riesgos estructurales.

Las cuatro categorías de riesgo AGI, según lo determinado por DeepMind.

Crédito: Google DeepMind

Las cuatro categorías de riesgo AGI, según lo determinado por DeepMind.

Crédito: Google DeepMind

El primer problema posible, el mal uso, es fundamentalmente similar a los riesgos actuales de IA. Sin embargo, debido a que AGI será más poderoso por definición, el daño que podría hacer es mucho mayor. Un hecho de que se haga bien con el acceso a AGI podría hacer mal uso del sistema para hacer daño, por ejemplo, al pedirle al sistema que identifique y explote vulnerabilidades de día cero o cree un virus de diseñador que podría usarse como una barra biológica.

DeepMind dice que las empresas que desarrollan AGI tendrán que realizar pruebas extensas y crear protocolos de seguridad posteriores al entrenamiento. Esencialmente, nuestras barandillas AI actuales sobre esteroides. También sugieren diseñar un método para suprimir las capacidades peligrosas por completo, a veces llamado “desaprendizaje”, pero no está claro si esto es posible sin limitar sustancialmente los modelos.